服务热线

0755-83647532

发表日期:2017-06-07 文章编辑:管理员 阅读次数:

机器学习 (ML) 正在迅速成熟。 如今,我们能够把大量数据输入机器学习应用中,后者能学会精确预测可能出现的结果。 随着训练数据集的扩大,深度学习 (DL) 模型的精确性呈指数级增长。 数以万亿的互联设备向系统发送数据,数据集的规模可达数百 TB。

机器学习革命的成果在无人驾驶汽车、实时欺诈检测、对假期照片中的人脸进行识别的社交网络等领域得到了很好的体现。它渗透各行各业,影响无处不在。

让我们揭开全新英特尔至强融核产品家族的神秘面纱,了解其在处理 ML 工作负载方面的非凡优势。 我还会分享两项早期性能测试结果,即分别在基于单节点英特尔至强处理器系统和基于 128 节点英特尔至强融核处理器的集群上运行 ML 工作负载时的情况。 最后,我会讲述我们为了优化软件库所付出的努力,展示几款流行的面向 x86 架构 的开源 ML 框架。

“英特尔® 至强 融核™ 处理器特性”

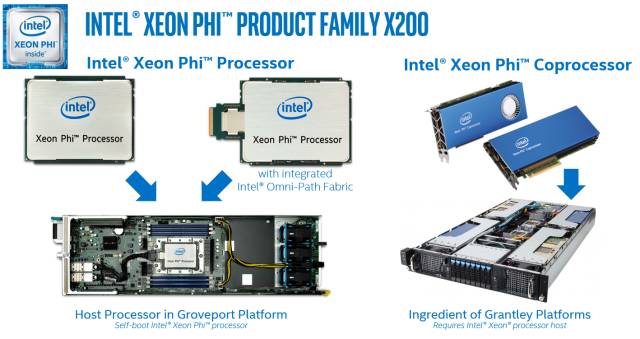

在设计第二代英特尔至强融核芯片时,我们发明了支持自启动的融核处理器 , 不需要在购买额外的处理器运行操作系统,也不需要通过 PCIe* 插槽传输数据。 (对于更喜欢把最新版英特尔至强融核芯片作为协处理器的用户,我们也有PCIe 卡版本。)

英特尔至强融核处理器 x200 包含 72 个处理器内核,每个内核支持 2 个英特尔® 高级矢量扩展指令集 512(英特尔® AVX-512)SIMD 处理单元,每内核浮点性能显著提升。 常用的 ML 算法均可从中受益,如浮点乘法和乘加融合指令 (FMA)。 英特尔至强融核处理器 x200 提供高达每秒 6 万亿次浮点运算的计算能力。 多核、多线程的功能和高带宽封装内存子系统(多通道 DRAM)及英特尔® Omni-Path 架构(英特尔® OPA)的集成结构技术相结合。

高带宽集成内存(高达 16 GB MCDRAM)保证数据快速传输到内核,并为平台额外提供高达 384 GB 商用 DDR4 内存。 程序员可以通过指定数据的大小及时间来管理内存。 MCDRAM 使用户可以灵活地对数据高速缓存,不必担心内存管理。 (MCDRAM 可以配置为三级高速缓存、非一致性内存访问 - 可分配内存和高速缓存和内存的混合组合。)

当处理大型 ML/DL 工作负载时,从一个节点到千百个节点的扩展能力是至关重要的。 借助英特尔 OPA 架构,英特尔至强融核处理器 x200 能够以近乎线性的方式扩展内核和线程。 在编码层面,通过架构可以最少的编程快速高效地从远程存储获取数据,并放入本地高速缓存。

这些创新为机器学习和深度学习提供了优质的训练时间。 比如,AlexNet 训练方面,相对于单节点而言,128 节点英特尔至强融核处理器 x200 的训练时间减少了 50 倍。 进行 GoogLeNet 训练时,32 节点英特尔至强融核处理器 x200 的扩展效率达到 87%,比最新公布的最高数据超出 38%。

应用只有并行化,才能利用大规模并行多核、多线程架构。 否则,你只能获得单核、单线程性能。

英特尔至强融核处理器 x200 的每个内核包含多个矢量处理单元,所以整体计算密度更高,成为抵消单核、单线程性能的一个因素。 因此,如果你的工作负载能受益于高水平的并行性和线程并行性,英特尔至强融核处理器把更多计算融入更小的区域,功耗低于其他解决方案。

“二进制兼容”

文章摘自英特尔精英汇

欢迎联系永信贵宾会集团咨询英特尔相关产品信息

永信贵宾会集团联系方式

咨询热线:400-830-0107

永信贵宾会官网:www.yyhsjs.com

客户垂询邮箱:Customer@yyhsjs.com

客户垂询QQ:1305742380

地址:深圳市福田区深南大道1006号国际创新中心C座11楼

邮编:518026

粤公网安备 44030402001885号

友情链接: 金沙古酒 | 中青宝 | 宝德控股 | 宝德计算 |

粤公网安备 44030402001885号

友情链接: 金沙古酒 | 中青宝 | 宝德控股 | 宝德计算 |